DL roam

来自Jack's Lab

(版本间的差异)

(→直观印象) |

(→直观印象) |

||

| 第22行: | 第22行: | ||

最右边是输出层, 对应0到9 10个数字. 如果已经训练好了, 一个手写的'3'的图片,在输出层将会得到 3这个神经元的值最接近1(最大可能性), 其他神经元,理想状态, 可能性最接近0 (或-1). | 最右边是输出层, 对应0到9 10个数字. 如果已经训练好了, 一个手写的'3'的图片,在输出层将会得到 3这个神经元的值最接近1(最大可能性), 其他神经元,理想状态, 可能性最接近0 (或-1). | ||

| + | |||

| + | 而且,有一个事情必须提到,每个神经元有一个可能性的度量值, 从[-1, +1],或者从[0,1], 一层层传递下去,构成正向反馈. | ||

| + | |||

| 第27行: | 第30行: | ||

每一层的每一个结点都全链接到下一层的所有神经元, 同样,靠右的神经元也全链接到上一层的所有神经元, 这样的结构叫 "FNN" 全链接神经网络. | 每一层的每一个结点都全链接到下一层的所有神经元, 同样,靠右的神经元也全链接到上一层的所有神经元, 这样的结构叫 "FNN" 全链接神经网络. | ||

| + | |||

| + | |||

| + | |||

| + | 那下一层的神经元怎么得到自己的 '可能性' 值, 有两个步骤. 第一, 计算Z<sup>l</sup> = (W<sup>l-1</sup><sub>1</sub>a<sup>l-1</sup><sub>1</sub> +b<sub>1</sub>) + ( W<sup>l-1</sup><sub>2</sub>*a<sup>l-1</sup><sub>2</sub> + b<sub>1</sub> ) ... | ||

| + | |||

| + | 这个式子的意思是有好几个: | ||

| + | * 每个神经元里有两个变量,一个叫w ( weight), 另一个叫做 b (bias 偏致). | ||

== 最小值 == | == 最小值 == | ||

== 卷积 == | == 卷积 == | ||

2018年7月2日 (一) 10:39的版本

目录 |

1 接触 Deep Learning

Jack 给我普及Deep learning已经是一两年前的事情了. 作为酒桌的谈资,自然是没往心里去. 直到我最爱的几个youtube频道相继开始聊起Deep learning的话题,才想起来探个究竟.

- 3Blue1Brown on youtube [1]

2 直观印象

无论是jack给的连接还是youtube频道3Blue1Brown, 都是用下面这个例子来作为介绍deep learning.

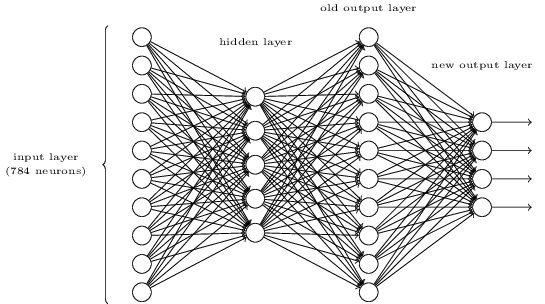

直接跳到这个神经元结构示意图, 是下面的这个样子.

什么意思呢, 就是假设每个手写数字都是28x28个像素的小图片, 总共784个点, 每个点的像素值按照一行行配列好,变成一个输入数组对应 input layer的784个神经元, 非常的直接和暴力.

神经元有四层, 中间两层称作 hidden layer.

最右边是输出层, 对应0到9 10个数字. 如果已经训练好了, 一个手写的'3'的图片,在输出层将会得到 3这个神经元的值最接近1(最大可能性), 其他神经元,理想状态, 可能性最接近0 (或-1).

而且,有一个事情必须提到,每个神经元有一个可能性的度量值, 从[-1, +1],或者从[0,1], 一层层传递下去,构成正向反馈.

好了, 一共有四层, 算是'深了', 所以叫 'deep learning', 而层数很少的呢叫 'shallow learning'.

每一层的每一个结点都全链接到下一层的所有神经元, 同样,靠右的神经元也全链接到上一层的所有神经元, 这样的结构叫 "FNN" 全链接神经网络.

那下一层的神经元怎么得到自己的 '可能性' 值, 有两个步骤. 第一, 计算Zl = (Wl-11al-11 +b1) + ( Wl-12*al-12 + b1 ) ...

这个式子的意思是有好几个:

- 每个神经元里有两个变量,一个叫w ( weight), 另一个叫做 b (bias 偏致).